您好,登录后才能下订单哦!

-

忘记密码?

请求超时!

请点击 重新获取二维码您好,登录后才能下订单哦!

请求超时!

请点击 重新获取二维码爬取小说网站的小说,并保存到数据库

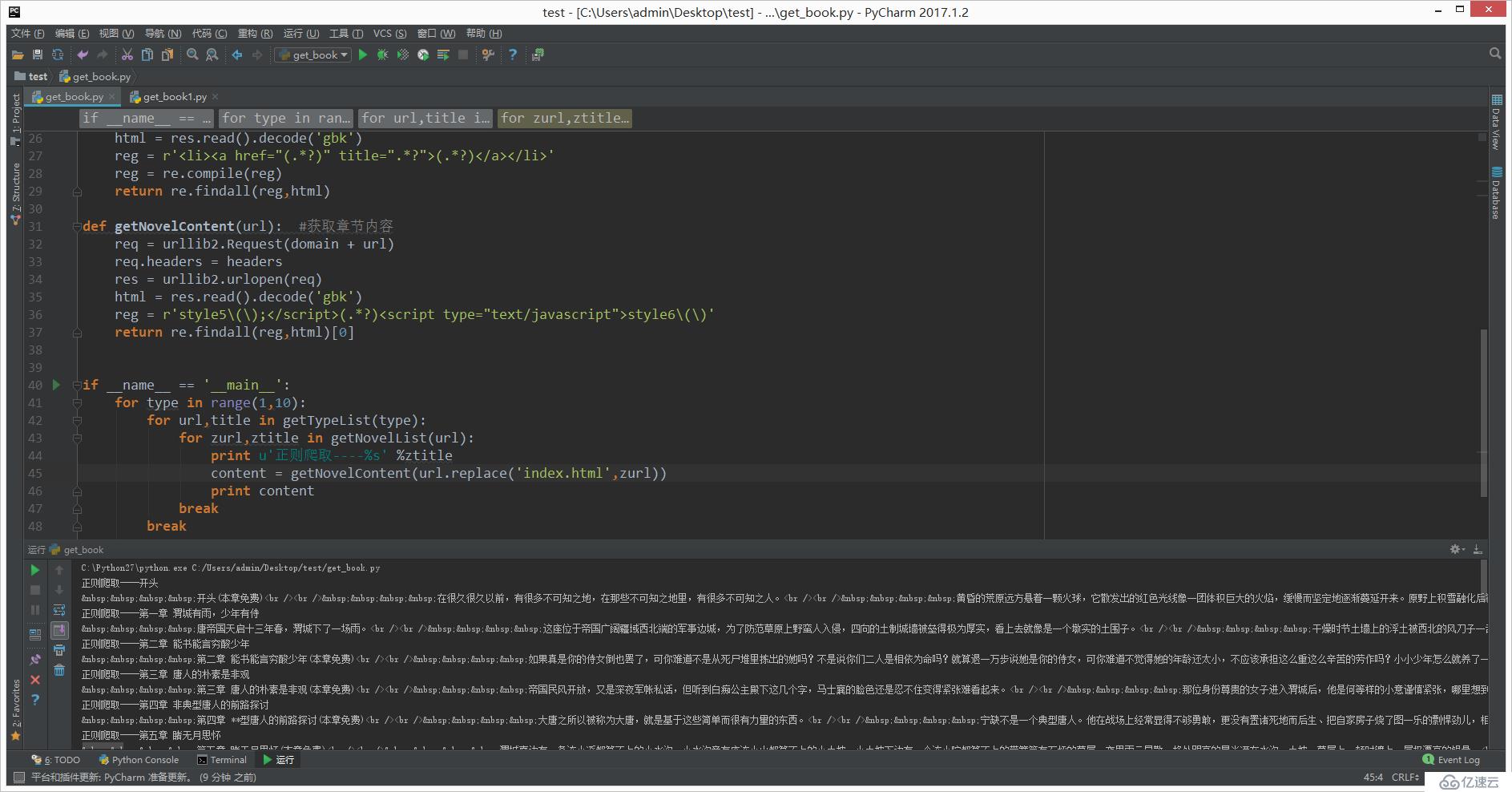

第一步:先获取小说内容

#!/usr/bin/python

# -*- coding: UTF-8 -*-

import urllib2,re

domain = 'http://www.quanshu.net'

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36"

}

def getTypeList(pn=1): #获取分类列表的函数

req = urllib2.Request('http://www.quanshu.net/map/%s.html' % pn) #实例将要请求的对象

req.headers = headers #替换所有头信息

#req.add_header() #添加单个头信息

res = urllib2.urlopen(req) #开始请求

html = res.read().decode('gbk') #decode解码,解码成Unicode

reg = r'<a href="(/book/.*?)" target="_blank">(.*?)</a>'

reg = re.compile(reg) #增加匹配效率 正则匹配返回的类型为List

return re.findall(reg,html)

def getNovelList(url): #获取章节列表函数

req = urllib2.Request(domain + url)

req.headers = headers

res = urllib2.urlopen(req)

html = res.read().decode('gbk')

reg = r'<li><a href="(.*?)" title=".*?">(.*?)</a></li>'

reg = re.compile(reg)

return re.findall(reg,html)

def getNovelContent(url): #获取章节内容

req = urllib2.Request(domain + url)

req.headers = headers

res = urllib2.urlopen(req)

html = res.read().decode('gbk')

reg = r'style5\(\);</script>(.*?)<script type="text/javascript">style6\(\)'

return re.findall(reg,html)[0]

if __name__ == '__main__':

for type in range(1,10):

for url,title in getTypeList(type):

for zurl,ztitle in getNovelList(url):

print u'正则爬取----%s' %ztitle

content = getNovelContent(url.replace('index.html',zurl))

print content

break

break执行后结果如下:

第二步:存储到数据库

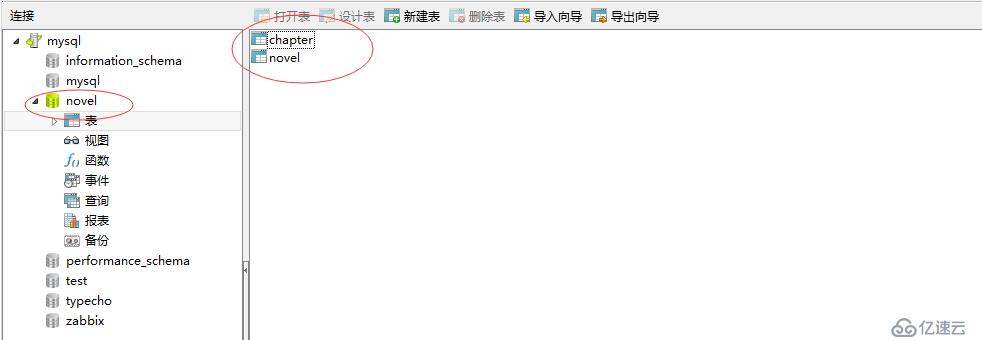

1、设计数据库

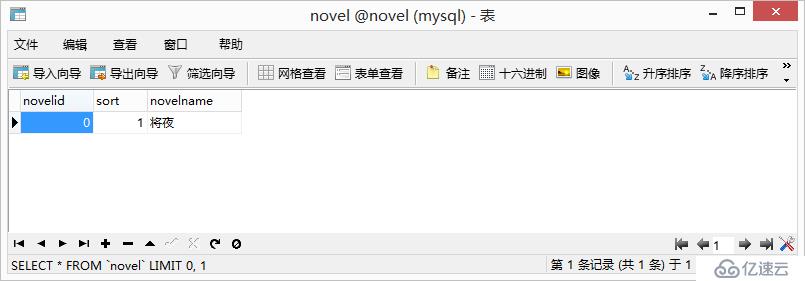

1.1 新建库:novel

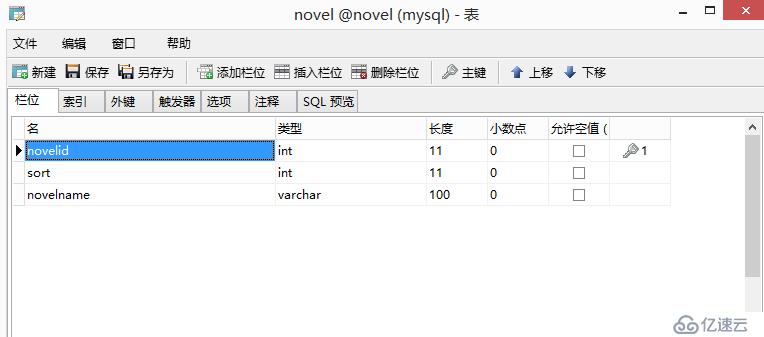

1.2 设计表:novel

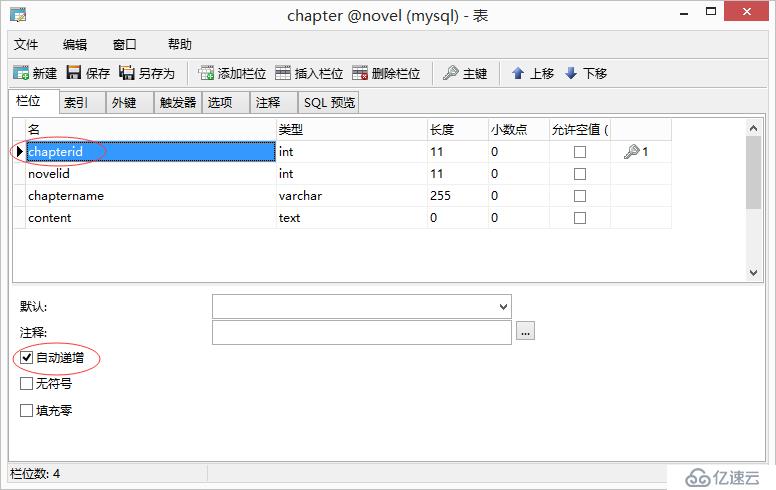

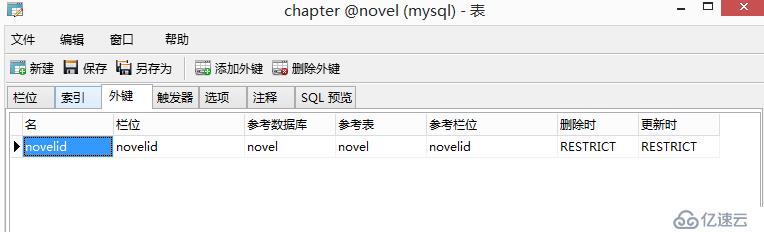

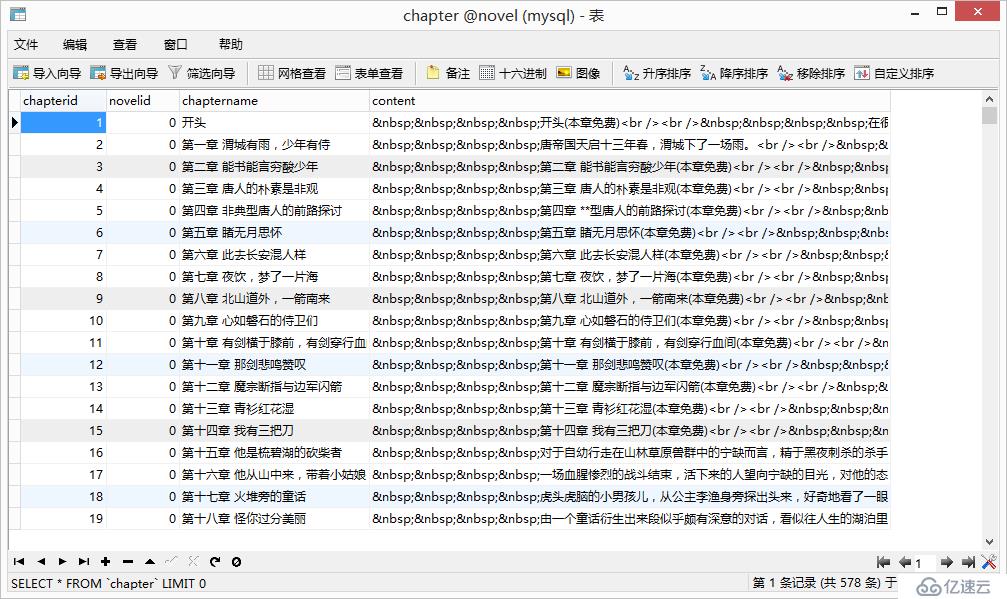

1.3 设计表:chapter

并设置外键

2、编写脚本

#!/usr/bin/python

# -*- coding: UTF-8 -*-

import urllib2,re

import MySQLdb

class Sql(object):

conn = MySQLdb.connect(host='192.168.19.213',port=3306,user='root',passwd='Admin123',db='novel',charset='utf8')

def addnovels(self,sort,novelname):

cur = self.conn.cursor()

cur.execute("insert into novel(sort,novelname) values(%s , '%s')" %(sort,novelname))

lastrowid = cur.lastrowid

cur.close()

self.conn.commit()

return lastrowid

def addchapters(self,novelid,chaptername,content):

cur = self.conn.cursor()

cur.execute("insert into chapter(novelid,chaptername,content) values(%s , '%s' ,'%s')" %(novelid,chaptername,content))

cur.close()

self.conn.commit()

domain = 'http://www.quanshu.net'

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36"

}

def getTypeList(pn=1): #获取分类列表的函数

req = urllib2.Request('http://www.quanshu.net/map/%s.html' % pn) #实例将要请求的对象

req.headers = headers #替换所有头信息

#req.add_header() #添加单个头信息

res = urllib2.urlopen(req) #开始请求

html = res.read().decode('gbk') #decode解码,解码成Unicode

reg = r'<a href="(/book/.*?)" target="_blank">(.*?)</a>'

reg = re.compile(reg) #增加匹配效率 正则匹配返回的类型为List

return re.findall(reg,html)

def getNovelList(url): #获取章节列表函数

req = urllib2.Request(domain + url)

req.headers = headers

res = urllib2.urlopen(req)

html = res.read().decode('gbk')

reg = r'<li><a href="(.*?)" title=".*?">(.*?)</a></li>'

reg = re.compile(reg)

return re.findall(reg,html)

def getNovelContent(url): #获取章节内容

req = urllib2.Request(domain + url)

req.headers = headers

res = urllib2.urlopen(req)

html = res.read().decode('gbk')

reg = r'style5\(\);</script>(.*?)<script type="text/javascript">style6\(\)'

return re.findall(reg,html)[0]

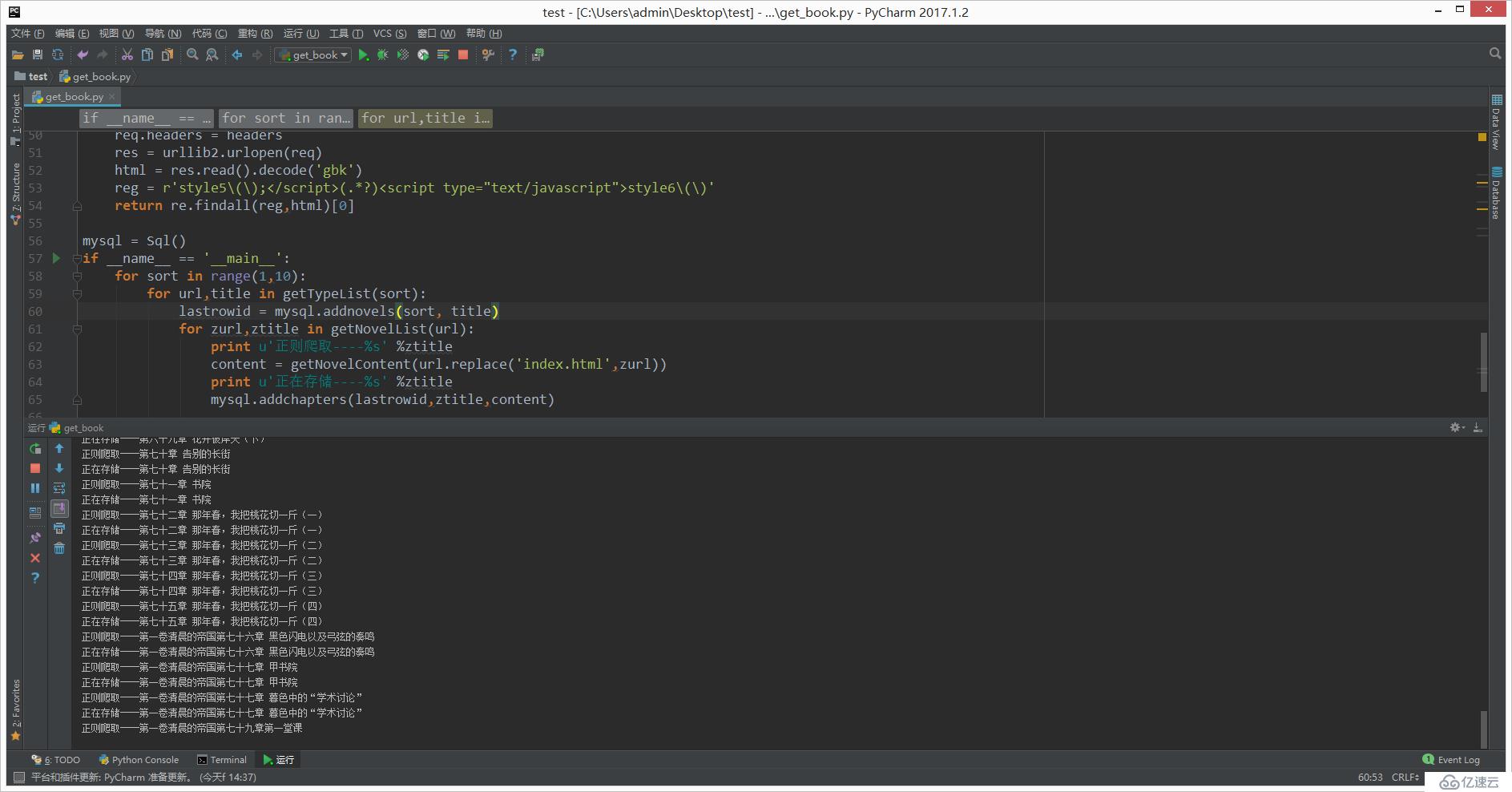

mysql = Sql()

if __name__ == '__main__':

for sort in range(1,10):

for url,title in getTypeList(sort):

lastrowid = mysql.addnovels(sort, title)

for zurl,ztitle in getNovelList(url):

print u'正则爬取----%s' %ztitle

content = getNovelContent(url.replace('index.html',zurl))

print u'正在存储----%s' %ztitle

mysql.addchapters(lastrowid,ztitle,content)3、执行脚本

4、查看数据库

可以看到已经存储成功了。

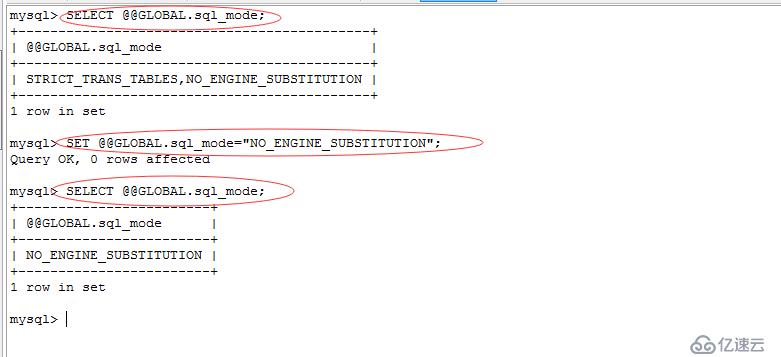

报错:

_mysql_exceptions.OperationalError: (1364, "Field 'novelid' doesn't have a default value")

解决:执行sql语句

SELECT @@GLOBAL.sql_mode;

SET @@GLOBAL.sql_mode="NO_ENGINE_SUBSTITUTION";

报错参考:http://blog.sina.com.cn/s/blog_6d2b3e4901011j9w.html

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。

玻璃钢生产厂家黑河人物玻璃钢雕塑制作好口碑的玻璃钢人像雕塑玻璃钢海洋雕塑哪家质量好张家口玻璃钢海豚雕塑厂家平凉城市玻璃钢雕塑公司玻璃钢雕塑模具定做厂家广州玻璃钢影视人物雕塑价格靠谱的商场美陈宁波玻璃钢商场美陈湖州公园玻璃钢雕塑生产厂家张家口玻璃钢雕塑哪家好无锡拉丝玻璃钢雕塑哪家好临沂公园玻璃钢雕塑价格玻璃钢雕塑如何清洗服务好有诚信的玻璃钢雕塑三明玻璃钢海豚雕塑厂家中国玻璃钢大公鸡雕塑天水公园玻璃钢雕塑定做商场玻璃钢雕塑价格珠海透光玻璃钢雕塑工艺厂家濮阳玻璃钢浮雕雕塑小品南平城市玻璃钢雕塑潮州玻璃钢飞马雕塑定制江西人物玻璃钢雕塑定制宜宾玻璃钢人物雕塑广西玻璃钢金属雕塑图片单县制作玻璃钢雕塑产品定制新余定制玻璃钢雕塑罗马柱玻璃钢雕塑图片玻璃钢雕塑坏处香港通过《维护国家安全条例》两大学生合买彩票中奖一人不认账让美丽中国“从细节出发”19岁小伙救下5人后溺亡 多方发声单亲妈妈陷入热恋 14岁儿子报警汪小菲曝离婚始末遭遇山火的松茸之乡雅江山火三名扑火人员牺牲系谣言何赛飞追着代拍打萧美琴窜访捷克 外交部回应卫健委通报少年有偿捐血浆16次猝死手机成瘾是影响睡眠质量重要因素高校汽车撞人致3死16伤 司机系学生315晚会后胖东来又人满为患了小米汽车超级工厂正式揭幕中国拥有亿元资产的家庭达13.3万户周杰伦一审败诉网易男孩8年未见母亲被告知被遗忘许家印被限制高消费饲养员用铁锨驱打大熊猫被辞退男子被猫抓伤后确诊“猫抓病”特朗普无法缴纳4.54亿美元罚金倪萍分享减重40斤方法联合利华开始重组张家界的山上“长”满了韩国人?张立群任西安交通大学校长杨倩无缘巴黎奥运“重生之我在北大当嫡校长”黑马情侣提车了专访95后高颜值猪保姆考生莫言也上北大硕士复试名单了网友洛杉矶偶遇贾玲专家建议不必谈骨泥色变沉迷短剧的人就像掉进了杀猪盘奥巴马现身唐宁街 黑色着装引猜测七年后宇文玥被薅头发捞上岸事业单位女子向同事水杯投不明物质凯特王妃现身!外出购物视频曝光河南驻马店通报西平中学跳楼事件王树国卸任西安交大校长 师生送别恒大被罚41.75亿到底怎么缴男子被流浪猫绊倒 投喂者赔24万房客欠租失踪 房东直发愁西双版纳热带植物园回应蜉蝣大爆发钱人豪晒法院裁定实锤抄袭外国人感慨凌晨的中国很安全胖东来员工每周单休无小长假白宫:哈马斯三号人物被杀测试车高速逃费 小米:已补缴老人退休金被冒领16年 金额超20万